話を聴く際、口の動きの視覚情報をどのように聴覚情報と統合するか

熊本大学文学部 認知心理学研究室の積山薫教授および札幌医科大学医学部 神経科学講座の篠崎淳助教、国際電気通信基礎技術研究所(ATR)らのグループは、対面話者の話を聴く際に脳内ネットワークの活性化の仕方が、日本語母語者と英語母語者で異なることを明らかにした。

画像はリリースより

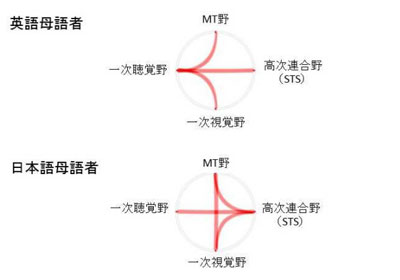

会話の際に、視覚的な情報である「口の動き」が音声の聞こえに影響を与え、視聴覚統合が生じることが広く知られている。積山教授らのこれまでの研究では、日本語母語者は、英語母語者ほどには視覚情報による影響を受けないことが分かっていた。そこで、同グループではfMRIを用いて日本語母語者と英語母語者(留学生)の大学生それぞれ約20名の脳活動を計測。英語母語者では、視覚的な運動情報を処理するMT野と一次聴覚野との機能的結合が日本語母語者より有意に強く、耳から聞こえる音の脳内処理と口の動きの脳内処理が密に連携していることが分かった。

日本語母語者は視聴覚の連携が弱い

これまでも、外国語学習において、音だけでは効果が見られないとの報告があり、話者の視覚情報も用いると効果的なのではないかという仮説があった。今回の調査は日本語母語者と英語母語者の音声知覚における視聴覚統合の行動的差異が、脳内ネットワークの活性化パターンの違いによるものであり、英語母語者は耳から聞こえる音の脳内処理と口の動きの脳内処理が密に連携しているのに対して、日本語母語者では、この連携が弱いという違いが明らかとなったとしている。

なおこの研究成果は、英オープン・アクセス・ジャーナル「Scientific Reports」に8月11日付けで掲載されている。

▼関連リンク

・熊本大学 プレスリリース